Cómo reemplazar un disco duro por una SSD en cuatro pasos

Si compras un PC nuevo tendrás poco donde elegir en el apartado del almacenamiento, porque prácticamente todos usarán unidades de estado sólido. Si tienes un equipo algo más antiguo debes saber que reemplazar un disco duro por una SSD es una de las actualizaciones más interesantes que puedes realizar para mejorarlo y extender su vida útil.

Son decenas los artículos que te hemos venido ofreciendo sobre esta tecnología de almacenamiento sólido que ha dejado obsoletos a los discos duros, incluyendo análisis de las mejores unidades del mercado y una Guía de compra reciente con todas las características que un usuario debe conocer y selección de ofertas. Hoy apostamos por un artículo más práctico donde te vamos a recordar los cuatro pasos para reemplazar de manera efectiva un disco duro por una SSD.

Para el tutorial. nos centraremos en un ordenador portátil, pero igual de sencillo sería hacerlo en una sobremesa y los beneficios de su instalación pensando en mejorar el rendimiento contundente, en cualquier caso, en tiempos de arranque del sistema operativo, en la apertura de aplicaciones, en la recuperación desde modos de suspensión o en el trasvase de archivos entre unidades internas o hacia soluciones externas.

1.- Elegir y comprar la SSD

Hasta hace un par de años las posibilidades (por oferta y precio) de comprar una SSD pasaban casi en exclusiva por el formato estándar de 2,5 pulgadas y la interfaz SATA. Hoy en día la oferta es mucho más amplia, las unidades conectadas a PCIe ocupan la mayoría de nuevos lanzamientos y son el formato recomendable siempre que tu equipo los soporte.

Si tu portátil tiene conectores M.2 – PCIe disponibles, no hay debate, éste es el factor de forma que debes comprar. La mejora en rendimiento, consumo y peso es notable y además, siempre podrías aprovechar la bahía de 2,5″ como unidad secundaria para aumentar el almacenamiento, sea con otras SSD SATA o incluso con los viejos discos duros que tengas arrinconados.

Si vas a montar una SSD de 2,5 pulgadas solo tendrás que valorar su grosor aunque no tendrás problema porque ya todos se ofrecen en tamaños de 9 o 7 mm. En cuanto a capacidad, dependerá de tus necesidades y presupuesto. Hay unidades baratísimas de 120 o 240 GB si quieres combinarla con otras unidades y buenos precios en 500 GB o 1 TB si las vas a montar como unidad única.

Todos los grandes fabricantes de SSD (WD, Kioxia, Samsung, Kingston…) te van a ofrecer una buena garantía y rendimiento. En cuanto a precios, las memorias flash NAND en las que están basadas han bajado de precio y ello se se ha trasladado al cliente final. Se pueden encontrar unidades muy económicas en cualquier tipo de formato y capacidad.

2.- Guardar los datos

Si la compra de la SSD viene motivada por el fallo de un disco duro no podremos hacer demasiado. Retirarlo de inmediato y en otro equipo utilizar herramientas especializadas del fabricante o de terceros para formateo a bajo nivel u otras. Si los fallos son parciales también lo quitaríamos para intentar salvar datos con aplicaciones de recuperación.

Si el disco duro está en uso y funciona bien, antes de cualquier acción de reemplazo tenemos que plantearnos la realización de copias de seguridad del disco. Ello dependerá de las necesidades de cada uno. Vemos varias posibilidades:

- Lo más completo sería una clonación total del disco duro para conservar sistema operativo, aplicaciones, archivos y configuración de usuario. Muchos fabricantes de SSD ofrecen aplicaciones para ello y terceros desarrolladores ofrecen apps gratuitas. Necesitarás una unidad externa para hacerlo o directamente en la SSD con kits de conversión y/o cableado que pase los datos desde un USB a la interfaz de la SSD, generalmente SATA.

- Si no necesitas una clonación puedes utilizar los discos de recuperación que te proporcionó el fabricante de tu portátil.

- Si no tienes discos de recuperación del fabricante o quieres crear copias de seguridad personalizadas, todos los sistemas operativos actuales ofrecen herramientas para realizar copias de seguridad que por otro lado es una tarea muy conveniente que forma parte del mantenimiento del propio sistema. También hay buenas apps de terceros que se pueden utilizar.

- Si vas a realizar una instalación limpia desde cero desde DVD/USB que tengas preparado con el sistema operativo, simplemente revisa el disco para guardar tus archivos personales (documentos, fotos…), que puedes archivar en cualquier medio o en el servicio de almacenamiento en nube que utilices.

Si lo necesitas, puedes revisar esta guía para mover Windows desde HDD a SSD manteniendo todos los datos.

3.- Montar el SSD

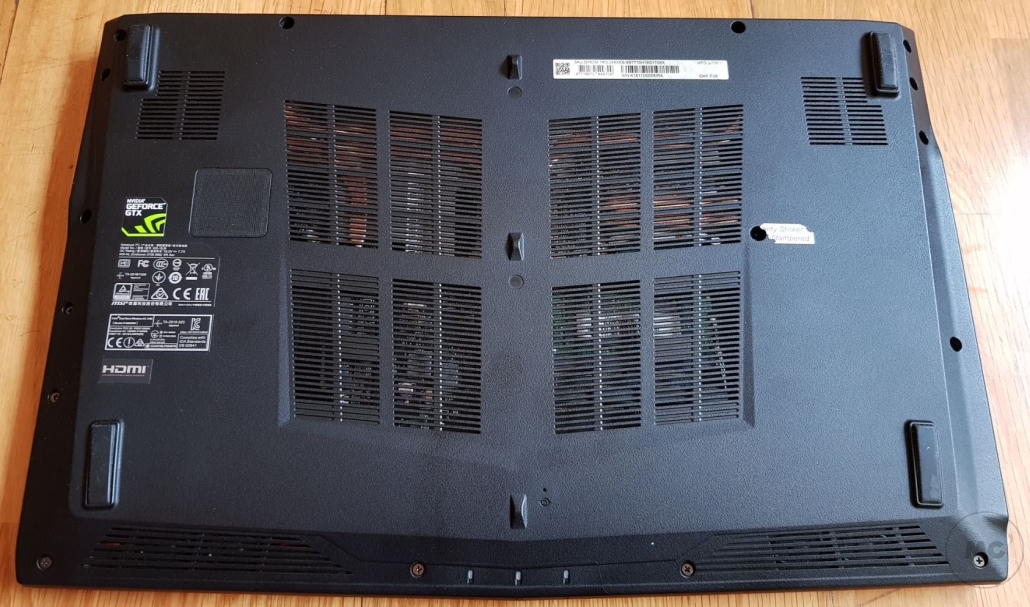

Una vez salvado los datos que necesitamos y teniendo a mano el disco de arranque o la copia de respaldo para instalar el sistema, vamos al montaje. Cada portátil es un mundo, pero revisando su parte trasera no tendremos demasiados problemas para localizar la situación del disco duro.

Hay modelos que tienen un hueco dedicado para la unidad de almacenamiento y otros en los que hay que desmontar toda la tapa. Retira cualquier tipo de periférico conectado al portátil, el cable de alimentación y la batería en su caso. Revisa la parte trasera y retira la tornillería para acceder a su interior.

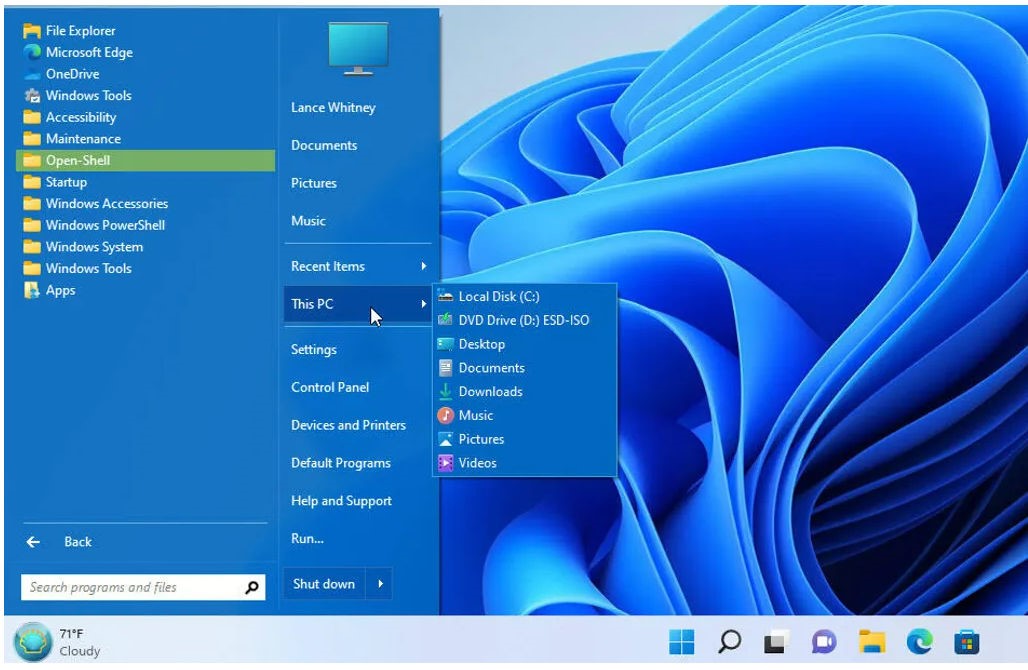

No será nada complicado localizar el disco duro instalado, como puedes ver en este portátil MSI Leopard que usamos como ejemplo. Si has elegido una SSD SATA, retira la sujeción del disco duro y reemplaza con la SSD.

Si has decidido montar una M.2 (porque como en este caso también cuenta con un slot disponible), es aún más sencillo, pinchando la SSD en el conector y asegurándola con un solo tornillo.

Poco más queda por hacer que volver a montar la tapa del portátil, conectar la batería, cable de alimentación o periféricos que tuviéramos instalado.

4.- Configuración, instalación del sistema y datos

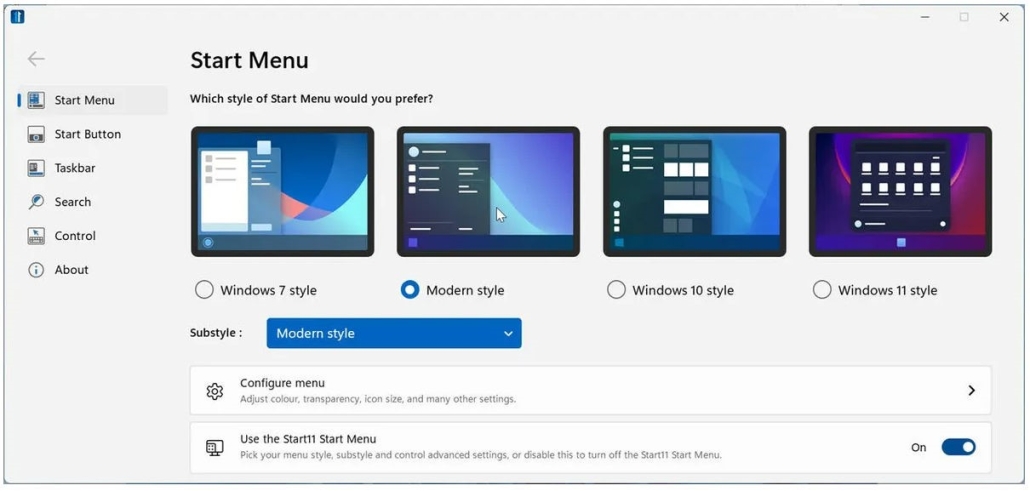

Si has utilizado una SSD a PCIe y vas a mantener también el disco duro (u otra SSD), asegúrate que la PCIe sea el primer dispositivo de arranque. Este apartado se configura en la BIOS/UEFI.

Si has realizado previamente una clonación solo tendrás que arrancar el equipo. Si no has hecho una clonación y has apostado por una copia de seguridad parcial, tendrás que instalar el sistema operativo y/o aplicaciones, restaurando la copia de seguridad o instalando desde cero. Se hace de la misma manera con cualquier versión de Windows o Linux.

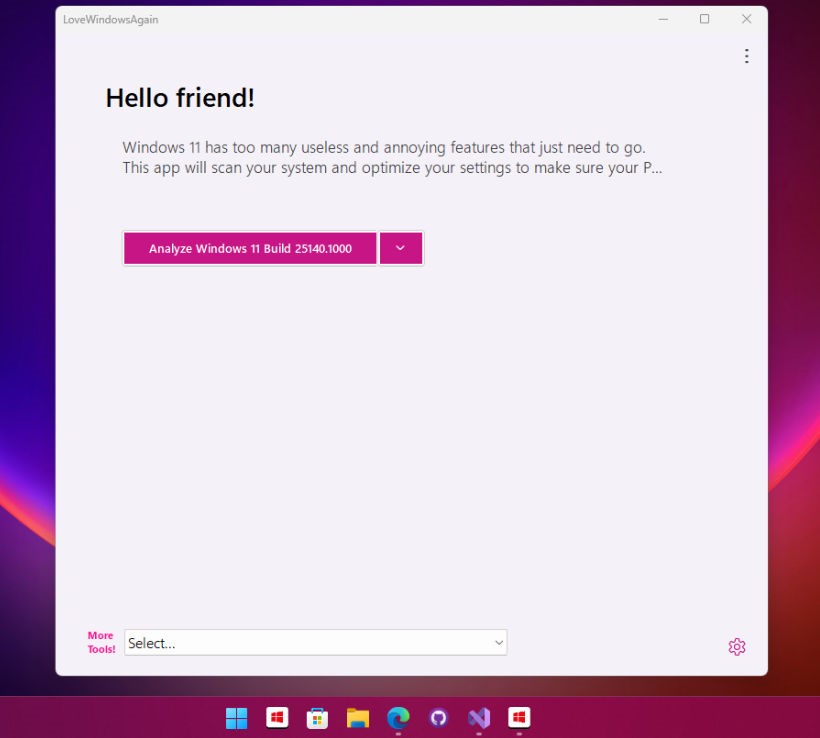

Después del primer arranque se recomienda configurar adecuadamente la SSD para trabajar en el equipo porque tiene algunas peculiaridades sobre los discos duros. Algunas ya las hemos comentado en otros artículos, como desactivar las desfragmentaciones o asegurarse que tenemos activado el comando TRIM.

La mayoría de fabricantes de SSD ofrecen una aplicación para su configuración que es recomendable activar, porque permite configurar la unidad para un rendimiento óptimo, visualizar su estado, mantener actualizado el firmware o cifrar los datos del disco si lo necesitamos.

No lo dudes. Reemplazar un disco duro por una SSD te va a ofrecer enormes ventajas, las más directas en el apartado del almacenamiento. Este tipo de actualización se puede realizar de la misma manera en un portátil que un PC de sobremesa. Los casos de uso son variados. Se puede montar una SSD PCIe (o SATA) única o acompañada de otras SSD o discos duros. Se recomienda instalar el sistema y las principales aplicaciones en la SSD más rápida y como primera unidad de arranque. A partir de ahí se abren distintas posibilidades para cubrir con garantías el almacenamiento interno de un PC.